Google Представляет T5Gemma 2: Модели с Мультимодальными Входами

Изучите T5Gemma 2 от Google, прогрессивную семью моделей, ориентированных на мультимодальность и долгий контекст для разработчиков.

Обзор

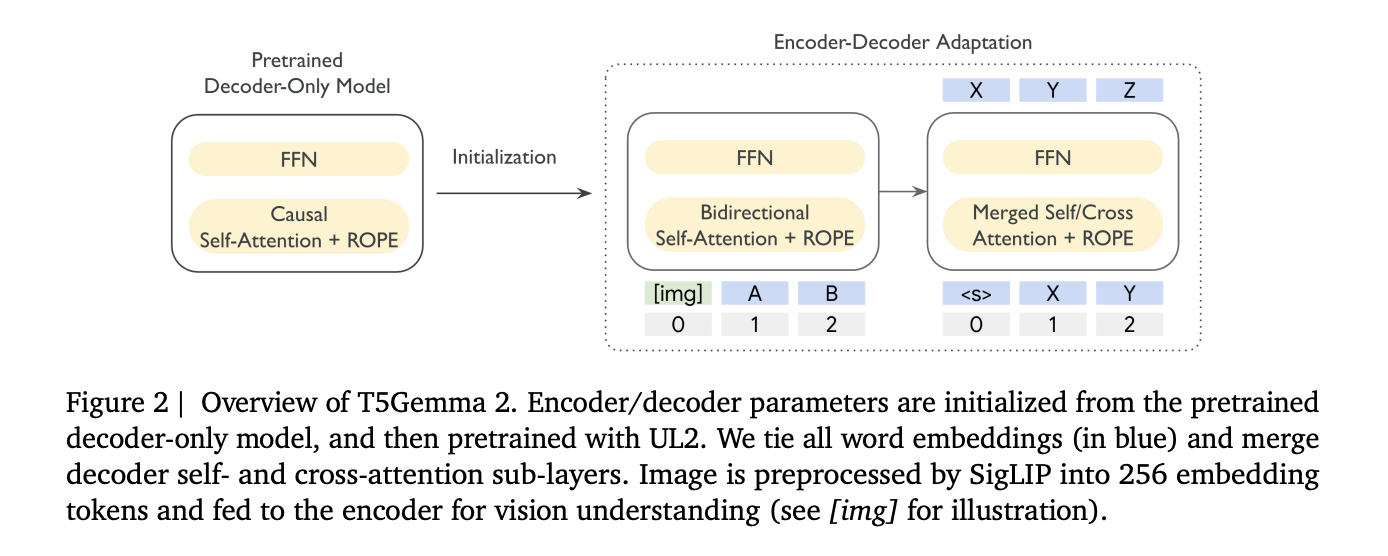

Google опубликовал T5Gemma 2, семейство открытых моделей энкодер-декодер Transformer, созданных путём адаптации предобученных весов Gemma 3 в структуре энкодер-декодер и продолжения предобучения с использованием цели UL2. Выпуск предназначен только для предварительного обучения, и Google явно отмечает, что не выпускает пост-обученные или IT контрольные точки.

Улучшения в T5Gemma 2

T5Gemma 2 является энкодер-декодером, аналогом Gemma 3, сохраняя те же самые базовые блоки и добавляя две структурные изменения для повышения эффективности малых моделей. Модели наследуют функции Gemma 3, важные для развертывания, в том числе мультимодальность, долгий контекст до 128K токенов и широкое многоязыковое покрытие, поддерживающее более 140 языков.

Что на самом деле выпустил Google?

В выпуск входят три предобученные модели: 270M-270M, 1B-1B и 4B-4B, где обозначение указывает на одинаковый размер энкодера и декодера. Без учёта визуального энкодера исследовательская команда сообщает о приблизительных общих значениях 370M, 1.7B и 7B параметров. Мультимодальная установка включает 417M параметров визуального энкодера вместе сEmbedding для энкодера и декодера.

Эффективные Энкодеры-Декодеры без Начала С Нуля

T5Gemma 2 следует концепции адаптации из T5Gemma, инициализируя энкодер-декодер из контрольной точки декодера и затем адаптируя с использованием UL2. Это уникальное разделение позволяет энкодеру считывать полный ввод двунаправленно, пока декодер фокусируется на авторегрессионной генерации, что существенно помогает в задачах долгого контекста, требующих поиска соответствующих доказательств из больших вводов.

Ключевые Изменения Эффективности

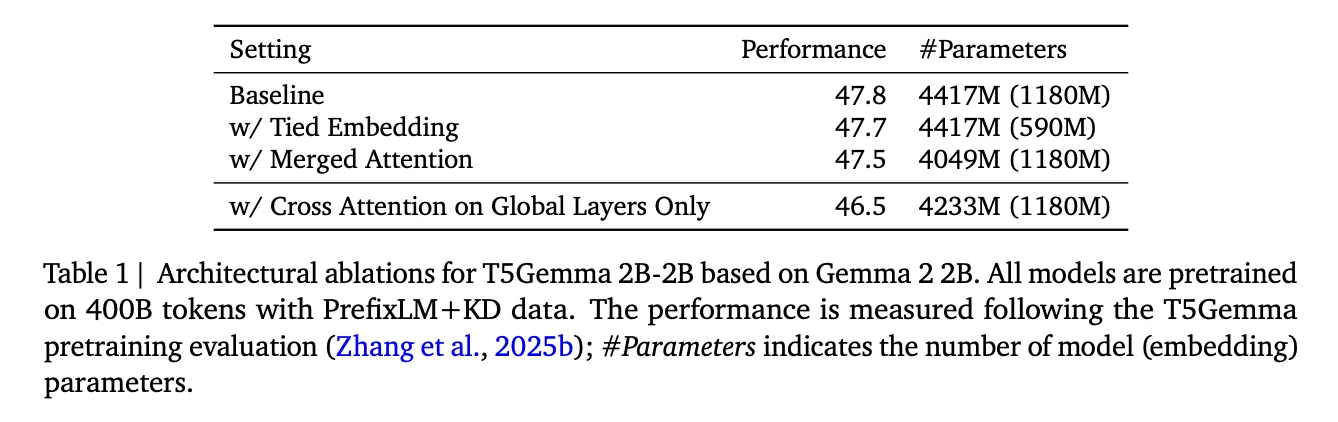

- Связанные словесные эмбеддинги: Общие эмбеддинги для энкодера, декодера и выходных слоёв уменьшают избыточность без значительных потерь качества.

- Объединённое внимание: Это новшество упрощает декодер, объединив само-внимание и перекрёстное внимание в единую операцию, облегчая инициализацию и демонстрируя экономию параметров с минимальным падением качества.

Мультимодальные Возможности

T5Gemma 2 является мультимодальным, переиспользуя визуальный энкодер Gemma 3, который остаётся замороженным во время обучения. Визуальные токены поступают в энкодер, где они могут взаимодействовать с текстовыми токенами в едином контексте. Система структурирована как изображение-текст-в-текст для облегчения проверки в мультимодальных сценариях.

Обеспечение Долгого Контекста

Контекстное окно 128K связано с чередованием локального и глобального внимания в Gemma 3. Дизайн включает повторяющийся паттерн из 5 локальных слоев скользящего окна, за которым следует глобальный слой, что снижает рост кеша ключей и значений, поддерживая возможность длинных контекстов в моделях с меньшим объёмом.

Подробности Настройки Обучения

Модели были предварительно обучены на 2T токенах с настройкой, которая включает размер пакета 4.2M токенов, косинусное снижение скорости обучения с 100 этапами разогрева и усреднение контрольных точек за последние 5 контрольных точек.

Ключевые Выводы

- T5Gemma 2 — это семейство энкодеров-декодеров, адаптированных от Gemma 3 и продолжающихся с использованием UL2.

- Google выпустил только предобученные контрольные точки; пост-обученные варианты не включены.

- Использует визуальный энкодер SigLIP для управления мультимодальными вводами.

- Включает ключевые изменения эффективности, такие как связанные эмбеддинги и объединённое внимание.

- Поддерживает длинную контекстную обработку до 128K токенов благодаря унаследованным дизайнам внимания.

Switch Language

Read this article in English