Сравнение: Трансформеры и Модель Микса Экспертов (MoE)

Исследуйте различия между трансформерами и моделями MoE в производительности и архитектуре.

Эффективность Моделей MoE

Вопрос:

Как модели MoE, имея гораздо больше параметров, могут работать быстрее при выводе?

Различия между Трансформерами и Моделями Микса Экспертов (MoE)

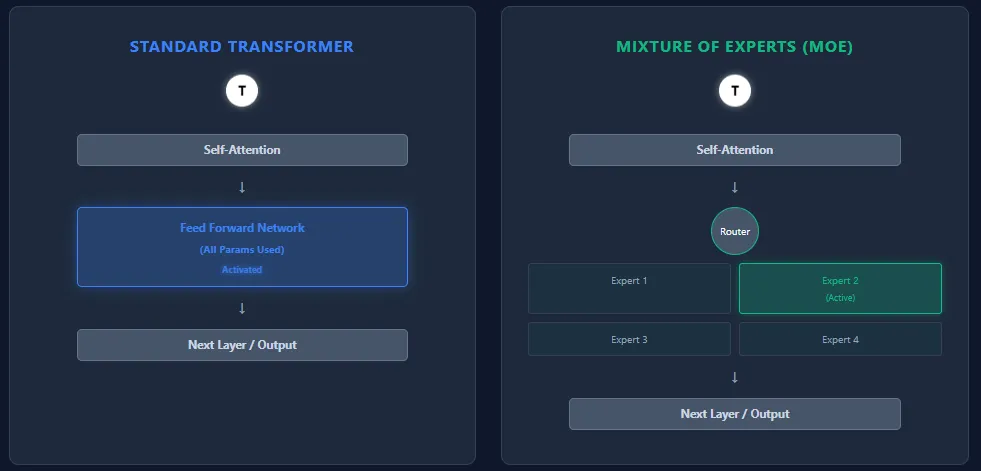

Трансформеры и модели Mixture of Experts (MoE) имеют общую архитектуру — слои самовнимания, за которыми следуют полносвязные слои, но они по-разному используют параметры и вычисления.

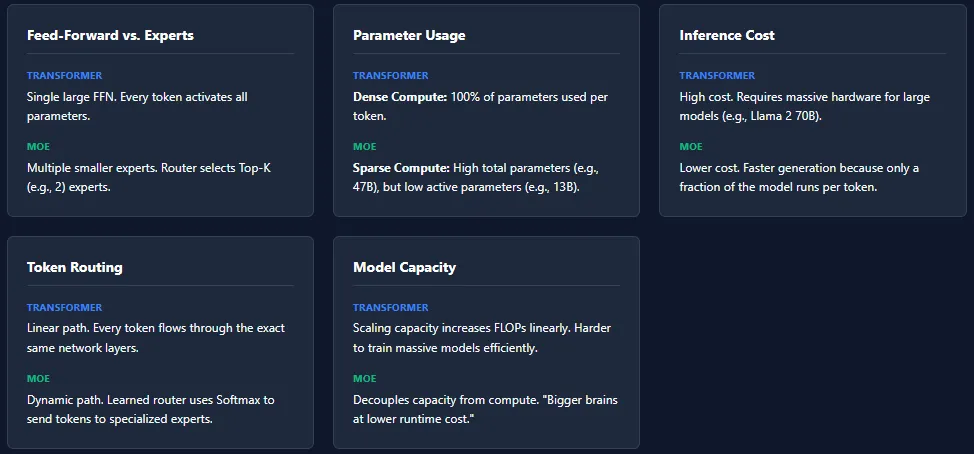

Полносвязная Сеть против Экспертов

- Трансформер: Каждое звено содержит одну большую полносвязную сеть (FFN), и каждый токен активирует все параметры при выводе.

- MoE: Заменяет FFN множеством меньших полносвязных сетей, называемых экспертами. Сетевое маршрутизирование выбирает только несколько экспертов (Top-K) на токен, так что задействована лишь небольшая часть всех параметров.

Использование Параметров

- Трансформер: Все параметры на всех уровнях используются для каждого токена → плотные вычисления.

- MoE: Имеет больше параметров в целом, но активирует только небольшую часть на токен → разреженные вычисления. Например, Mixtral 8×7B имеет 46.7B параметров, но использует лишь ~13B на токен.

Стоимость Вычислений

- Трансформер: Высокая стоимость вывода из-за полной активации параметров. Масштабирование до моделей, таких как GPT-4 или Llama 2 70B, требует мощного оборудования.

- MoE: Низкая стоимость вывода, поскольку активно только K экспертов на слой. Это делает модели MoE быстрее и дешевле в работе, особенно в больших масштабах.

Маршрутизация Токенов

- Трансформер: Нет маршрутизации. Каждый токен следует тем же управляющим путям через все слои.

- MoE: Обученный маршрутизатор назначает токены экспертам на основе оценок softmax. Разные токены выбирают различных экспертов, что добавляет специализацию и емкость модели.

В емкость Модели

- Трансформер: Для увеличения емкости единственным вариантом является добавление уровней или увеличение FFN — оба варианта значительно увеличивают FLOPs.

- MoE: Может масштабировать общее число параметров без увеличения вычислений на токен, что позволяет создавать «большие мозги при низких затратах на выполнение».

Хотя архитектуры MoE предлагают огромную емкость с низкой стоимостью вывода, они также представляют собой несколько проблем при обучении. Наиболее распространенной является коллапс экспертов, когда маршрутизатор многократно выбирает одних и тех же экспертов, оставляя других недообученными.

Несоответствие нагрузки является еще одной проблемой — некоторые эксперты могут получать значительно больше токенов, чем другие, что приводит к неравномерному обучению. Чтобы решить эту проблему, модели MoE полагаются на такие техники, как инъекция шума в маршрутизации, маскирование Top-K и пределы возможностей экспертов.

Эти механизмы обеспечивают активность и баланс всех экспертов, но также делают системы MoE более сложными для обучения по сравнению со стандартными трансформерами.

Switch Language

Read this article in English